Définition de féminisme

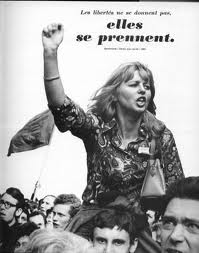

Du latin femĭna (« femme »), le féminisme est la doctrine sociale favorable à la femme. Il s’agit d’un mouvement qui exige que les hommes et les femmes aient les mêmes droits : ceci dit, il concède au sexe féminin des capacités qui n’étaient réservées qu’aux hommes auparavant.

Le féminisme met en cause les relations entre la sexualité (en tant que genre) et le pouvoir social, économique et politique. En révisant l’histoire, les féministes considèrent que le patriarcat a été négatif pour la société et que les femmes ont été soumises à la volonté de l’homme.

Il est important de tenir compte qu’il y a des hommes qui sont féministes (c’est-à-dire, qui donnent raison et qui soutiennent le mouvement), et que ni toutes les femmes se considèrent féministes. Certaines femmes acceptent le rôle social qu’occupe le genre et le perçoivent comme une réalité culturelle qui ne devrait pas être censurée.

Le féminisme a commencé à être visible à partir du XXe siècle dans les sociétés occidentales, où il a obtenu d’importantes réussites. Le droit de voter ou de demander le divorce et les conditions d’emploi égalitaires sont quelques-uns des progrès les plus notables, bien qu’il reste encore un bon bout de chemin à faire avant de parvenir à l’égalité des droits.

Certaines questions sont polémiques y compris au sein des propres groupes féministes, comme le cas de l’avortement. Certaines femmes considèrent que l’avortement fait partie de leurs droits sur leur propre corps alors que d’autres trouvent que cette pratique est un crime (l’assassinat d’un nouvel être humain). Toutefois, le mouvement féministe n’est pas uniforme et n’agit pas en masse.